|

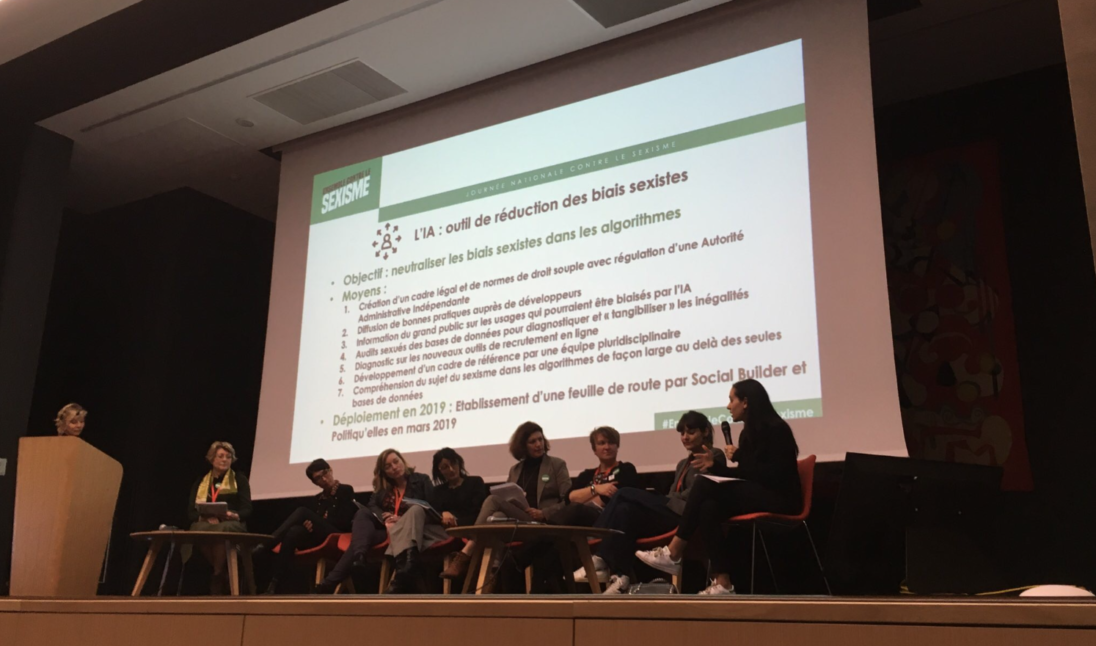

Le 24 janvier dernier s’est tenue la 2ème Journée Nationale contre le Sexisme mise en place par le collectif Ensemble contre le Sexisme. A cette occasion, Social Builder et Politiqu’elles ont organisé une table ronde sur le thème de l’Intelligence Artificielle et du Sexisme avec Hugo Ruggieri, Responsable juridique & DPO chez Doctrine.fr, Isabelle Collet, Maîtresse d’enseignement et de recherche en science de l’éducation à l’Université de Genève et Vice-présidente du Conseil d’administration de l’INSA Lyon, et Frédéric Bardolle, membre des collectifs AlgoTransparency & Data for Good.

|

Le constat est unanime, l’Intelligence Artificielle et les algorithmes associés reproduisent les comportements discrétoires voire les accentuent. En effet, le machine learning s’appuyant sur des datas et observations discriminants, les résultats d’aide à la décision accentueront les biais sexistes. Par exemple, l’aide à la décision à l’embauche d’Amazon s’est appuyée sur les données des employés déjà présents, à large majorité masculine, et a donc exclu les candidatures de femmes. De plus, comme le souligne Isabelle Collet, au-delà du machine learning, les avatars sont créés par des humains et s’imprègnent des stéréotypes de genre.

Quelles solutions ?

- Plus de femmes dans les métiers numériques, lutter contre la censure sociale et les stéréotypes étant de vraies barrières pour les femmes.

« L’Intelligence artificielle #IA : comment éviter la reproduction de #stéréotypes #sexistes ? »

Isabelle Collet souligne que si les #usages du #numérique sont pour toutes et tous, sa #maîtrise n’est réservée qu’à quelques uns, et surtout des hommes !#EnsembleContreLeSexisme pic.twitter.com/3r0eI9vWot— Céline Calvez (@celinecalvez) January 24, 2019

- Clarifier le cadre légal, transparence, accès aux données, responsabilité des plateformes, grâce à des initiatives comme le serment d’Hippocrate pour Data scientist

Au delà de la sensibilisation : quel cadre legal ? @HugoRuggieri :

• Obligation de loyauté et de transparence

• Indiquer les données des algorithmes #nosexism #IntelligenceArtificielle #AIforall pic.twitter.com/nowvC7gBuQ— Politiqu'elles (@Politiquelles) January 24, 2019

- Prendre en compte ces biais pour faire de l’Intelligence Artificielle un outil contre les discriminations

En conclusion, les recommandations sont à la fois de permettre une bonne connaissance du phénomène par des audits sexués et l’accès aux données, d’intégrer les biais sexistes dans la mise au point d’algorithmes pour mieux les limiter et promouvoir les femmes au sein du numérique.

Nous remercions nos intervenantes et intervenants pour cette conférence passionnante, et à l’intérêt porté pour cette thématique !